Les gains de productivité de 2010 à 2019 en France : le rôle des performances productives et des réallocations

Sébastien Bock, Aya Elewa et Sarah Guillou

L’évolution de la productivité agrégée est un déterminant essentiel de la croissance économique. La productivité mesure l’efficacité avec laquelle les ressources productives sont mobilisées pour produire de la valeur. Elle résulte directement des performances productives des entreprises qui elles-mêmes découlent de la capacité des entreprises à optimiser leur processus de production dans un environnement en constante évolution.

Néanmoins, l’évolution de la productivité agrégée dépend aussi de la réallocation des ressources. Ces mouvements de ressources se manifestent par le déplacement des parts de marché entre entreprises pérennes mais aussi par l’entrée et la sortie d’entreprises résultant des dynamiques industrielles et concurrentielles.

Le rapport sur le tissu productif français publié par l’OFCE le 18 octobre 2023 analyse l’évolution de la productivité en France sur la décennie 2010-2019. Il interroge dans quelles mesures les performances productives des entreprises et les réallocations de ressources contribuent à l’évolution de la productivité et quels sont les secteurs générateurs de gains de productivité. Ce post synthétise ses principaux résultats et envisage les perspectives futures.

Des gains de productivité modestes au cours de la dernière décennie

L’analyse de l’évolution de la productivité nécessite tout d’abord de mesurer l’efficacité avec laquelle les entreprises produisent. Pour ce faire, nous estimons la productivité globale des facteurs (PGF) de chaque entreprise selon la méthode de Wooldridge (2009). Les données d’entreprises mobilisées proviennent des fichiers FARE et de la base tous salariés (BTS) de l’INSEE de 2010 à 2019. Nous considérons uniquement les entreprises du secteur marchand hors agriculture, immobilier et finance.

Ensuite, nous agrégeons les PGF des entreprises pour obtenir la PGF agrégée[1]. Cet indicateur mesure l’efficacité avec laquelle l’ensemble des facteurs de production tels que la main-d’œuvre, le capital et les matières premières se combinent pour produire les biens et services. L’augmentation de la PGF mesure le supplément de production qui n’est pas imputable à l’accroissement de ces facteurs de production mais qui provient d’un ensemble de phénomènes tels que le progrès technique, l’innovation, les changements institutionnels, des changements organisationnels et des caractéristiques idiosyncratiques des entreprises. Les résultats indiquent que la productivité agrégée du secteur marchand tel que défini plus haut croît modérément de 3,2 % sur l’ensemble de la période 2010-2019.

Enfin, nous décomposons l’évolution de la PGF agrégée selon la méthode de Melitz et Polanec (2015). Le taux de variation de la PGF entre 2010 et 2019 est donc décomposé en trois composantes principales :

Evolution de la productivité en pourcentage = Effet d’apprentissage des entreprises pérennes + Effet d’allocation des entreprises pérennes + Effet net des entrées d’entreprises.

L’effet d’apprentissage (EP) mesure la contribution de l’évolution de la productivité interne des entreprises pérennes à structure de marché fixe. Il capture l’influence de l’évolution des performances productives au sein des entreprises issue d’une utilisation plus efficace de leurs ressources. L’effet d’allocation (EA) mesure la contribution des déplacements des parts de marché entre entreprises pérennes. L’effet net des entrées (EN) détermine dans quelle mesure les déplacements de ressources issus des entrées et sorties d’entreprises contribuent aux gains de productivité. Ce dernier terme correspond à la somme des contributions des entrées et sorties d’entreprises.

Des gains de productivité tirés par la réallocation de l’activité entre entreprises pérennes et affectés par la détérioration des performances productives internes des entreprises

Les enseignements de la décomposition montrent que les entreprises pérennes contribuent pour 3,7 points de pourcentage (pp) aux gains de productivité agrégée grâce à la réallocation de l’activité entre entreprises pérennes, des moins productives vers les plus productives (6,9 pp) alors que l’évolution de la productivité interne des entreprises contribue négativement (-3,2 pp). Les entrées d’entreprises concourent négativement à l’évolution de la productivité agrégée pour -9,2 pp tandis que les sorties concourent positivement pour 8,7 pp. Dès lors, l’effet net des entrées est de -0,5 pp. Les entrées-sorties contribuent donc négativement à l’évolution de la productivité mais l’effet est quantitativement faible. Finalement, les gains de productivité de la décennie pré-Covid résulte d’une dynamique de restructuration de l’activité plutôt que d’une amélioration des performances productives propres aux entreprises pérennes.

Une hétérogénéité sectorielle importante mais une meilleure allocation des ressources dans les secteurs affichant des gains de productivité

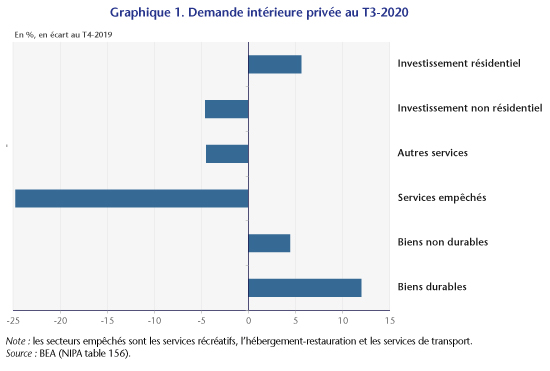

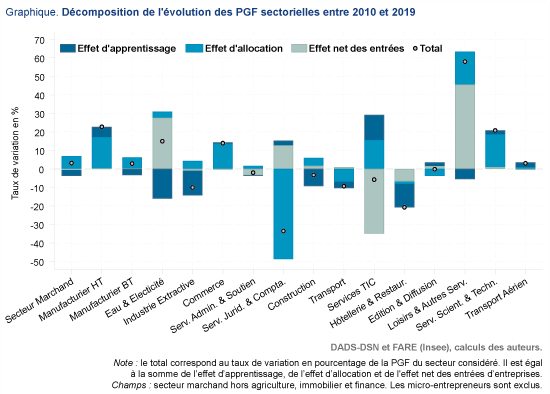

On constate une forte hétérogénéité dans l’évolution de la productivité des différents secteurs. Le graphique 1 reporte la décomposition de l’évolution des productivités sectorielles ainsi que celle du secteur marchand dans son ensemble. Certains secteurs voient leur productivité croître comme le secteur manufacturier de haute technologie (HT) et de basse technologie (BT), l’eau et l’électricité, le commerce, les loisirs et autres services, les services scientifiques et techniques et le transport aérien. En revanche, l’industrie extractive, les services TIC, les services juridiques et comptables, le transport, la construction et l’hôtellerie-restauration affichent une productivité décroissante entre 2010 et 2019.

Bien qu’on retrouve aussi une disparité dans les déterminants de l’évolution des productivités sectorielles, l’effet d’allocation contribue toujours positivement pour les secteurs qui affichent des gains de productivité. La PGF du secteur du manufacturier de haute technologie croît de 22,8 %. L’effet d’allocation y contribue pour 17 pp s’ajoutant aux 5,5 pp de l’effet d’apprentissage. Le secteur du manufacturier basse technologie connaît une croissance de 2,9 % de sa productivité. L’effet d’allocation explique pour 3,9 pp de cette croissance mais il est en grande partie effacé par un effet d’apprentissage négatif de -3,3 pp. De même, la PGF du secteur du commerce croît de 14 % dont 13,7 pp lié à l’effet d’allocation entre entreprises pérennes. La PGF des services scientifiques et technologiques connaît une croissance de 20,8 % tirée principalement par l’effet d’allocation pour 17,7 pp.

Au sein des secteurs où la productivité décline, on observe généralement une contribution négative de l’effet d’apprentissage. La productivité des industries extractives décroît de 10 %. Cette décroissance est entièrement tirée par l’effet d’apprentissage pour -13,4 pp. On observe le même effet pour les secteurs de la construction, l’hôtellerie et la restauration et le transport. Ces secteurs ont une productivité qui décroît de 3,3 %, 21 % et 9,2 % respectivement. Cette décroissance est tirée par l’effet négatif d’apprentissage pour respectivement -9,2 pp, -12,7 pp et -3,5 pp. En revanche, on distingue quelques exceptions dans les services. La productivité des services TIC diminue de 5,7 %. Cette diminution est gouvernée par l’effet net négatif des entrées d’entreprises (- 34,9 pp) qui est en partie compensée par l’effet positif d’apprentissage (13,6 pp). Ce secteur affiche donc une amélioration des performances productives des entreprises pérennes mais les entrées-sorties ont dégradé la productivité de ce secteur. La productivité du secteur des services juridiques et comptables a chuté de 33,5 % alors que l’effet d’apprentissage et l’effet net des entrées ont limité cette baisse.

Les dynamiques de productivité intra-sectorielles plus que les réallocations d’activité entre secteurs gouvernent l’évolution agrégée

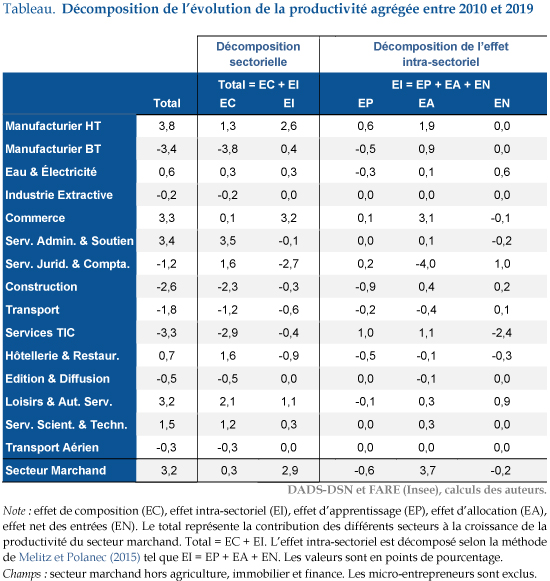

Bien que les tendances de productivité propres à chaque secteur influent sur les gains de productivité agrégée, les modifications de la composition sectorielle peuvent y contribuer également. Ainsi, les variations de la productivité agrégée sont décomposées en un effet de composition (EC) et un effet intra-sectoriel (EI). Le premier effet mesure la contribution des changements de composition sectorielle en matière de valeur ajoutée à niveau de productivité sectorielle donné. Le second effet quantifie la contribution des variations des productivités sectorielles à composition donnée. L’effet intra-sectoriel est décomposé comme précédemment selon la méthode Melitz et Polanec (2015). Le tableau affiche les résultats de ces décompositions.

À structure sectorielle d’activité constante, la PGF agrégée aurait crû de 2,9 % tandis qu’à productivités sectorielles constantes, elle aurait crû de seulement 0,3 %. Ainsi, les dynamiques intra-sectorielles de productivité contribuent pour près de 90 % à la croissance de la PGF sur la période 2010-2019. Les gains de productivité issus des dynamiques intra-sectorielles de productivité proviennent principalement de trois secteurs : le manufacturier de haute technologie (2,6 pp), le commerce (3,2 pp) et les loisirs et autres services (1,1 pp). Conformément aux résultats énoncés précédemment, l’effet d’allocation explique la totalité de l’effet intra-sectoriel avec une contribution de 3,7 pp. L’activité s’est déplacée vers des entreprises relativement plus productives au cours de la période au sein des secteurs. Là encore, le secteur manufacturier de haute technologie, le commerce et les loisirs et autres services sont les principaux contributeurs pour respectivement 1,9 pp, 2,1 pp et 0,3 pp. Au contraire, l’effet d’apprentissage et l’effet net des entrées intra-sectoriel contribuent négativement à l’évolution de la productivité agrégée pour -0,6 pp et -0,2 pp respectivement.

La contribution positive du changement de structure sectorielle indique que l’activité économique s’est légèrement déplacée vers des secteurs en moyenne plus productifs au cours de cette période. Les gains de productivité issus du changement de composition sectorielle de l’activité proviennent du déplacement de l’activité du secteur du Manufacturier de basse technologie (-3,8 pp), de la construction (-2,3 pp), des services TIC (-2,9 pp) et du secteur du transport (-1,2 pp) vers le manufacturier de haute technologie (1,3 pp), des services administratifs (3,5 pp), des services juridiques et comptables (1,6 pp), des loisirs et autres services (2,1 pp), de l’hôtellerie et de la restauration (1,6 pp) et des services scientifiques et techniques (1,2 pp).

La perspective de gains de productivité futurs fragilisée par un environnement économique turbulent

L’analyse des composantes de la dynamique de la productivité agrégée indique que les gains de productivité de 2010 à 2019 en France ont principalement été tirés par les réallocations de l’activité entre entreprises pérennes. Les entreprises les plus productives ont gagné des parts du marché. Ces gains de productivité reposent sur la prépondérance des dynamiques intra-sectorielles de productivité plutôt que de changements de composition sectorielle de l’activité. Au contraire, les performances productives internes des entreprises pérennes se sont détériorées. Ce dernier résultat interroge sur la pérennité de la croissance économique à moyen et à long terme. Cette inquiétude n’a guère été évincée par les évolutions issues du choc de la pandémie.

En effet, une analyse préliminaire du début de la crise sanitaire montre une chute de la productivité issue d’une détérioration accrue des performances productives internes des entreprises, soulignant la difficulté des entreprises à ajuster leur capacité de production au choc de demande et aux restrictions sanitaires imposées. En outre, la mise en place massive d’aides de soutien aux entreprises par le gouvernement, si elle a permis d’éviter un délitement du tissu productif, a probablement partiellement bloqué la réallocation des ressources vers les entreprises plus productives (Guillou, Mau et Treibich, 2023).

La résolution de la crise devrait conduire à une résorption progressive de la chute de productivité (Valla et Aussilloux, 2023). D’une part, la levée des restrictions sanitaires permet un retour à la normale de l’activité améliorant mécaniquement les performances productives internes des entreprises. D’autre part, la capacité d’adaptation organisationnelle des entreprises durant la crise engendrera probablement aussi des gains de productivité. Par exemple, le développement de la pratique du télétravail pourrait impacter positivement la productivité des entreprises selon les conditions de sa mise en place (Bergeaud, Cette et Drapala, 2023), tout comme les investissements réalisés en logistique et en numérisation de l’appareil productif entrepris pendant la crise (Banque de France, 2022).

Néanmoins, des éléments plus récents sur l’évolution de l’environnement économique ne laissent pas présager un rattrapage rapide de la productivité à son niveau d’avant crise. Les entreprises feront face à des difficultés croissantes à ajuster leur capacité de production. Par exemple, les difficultés d’approvisionnement et les tensions sur le marché du travail impacteront très certainement la capacité des entreprises à ajuster leur processus de production aux évolutions de la demande (Dauvin, 2022 ; OFCE, 2022). En outre, la politique monétaire restrictive menée par la Banque Centrale Européenne à travers la montée des taux d’intérêt réduira l’accès au crédit des entreprises alors qu’elles sortent de la crise plus endettées (Banque de France, 2023). Les effets sur la productivité d’une telle politique sont ambigus (Aghion et al., 2018). D’une part, une dégradation de l’accès au crédit réduit la capacité des entrepreneurs à innover affectant ainsi négativement les performances productives internes des entreprises. D’autre part, cette détérioration de l’accès au crédit peut accélérer la sortie du marché des entreprises les moins productives et potentiellement offrir des opportunités à de nouvelles entreprises plus performantes et innovantes, entraînant ainsi une amélioration de l’efficacité allocative. Enfin, la nécessité de la transition écologique offre de nouvelles opportunités économiques mais impose aussi aux entreprises de s’adapter à de nouvelles contraintes qui ne manqueront pas de marquer le tissu productif (Pisani-Ferry et Mahfouz, 2023 ; Valla et Aussilloux, 2023).

[1] La PGF agrégée correspond à la moyenne des logarithmes des PGF des entreprises pondérés par leur poids dans la valeur ajoutée.