Le casse-tête de l’inflation dans la zone euro : c’est la tendance, pas le cycle!

Par Thomas Hasenzagl, Filippo Pellegrino,

Lucrezia Reichlin, Giovanni Ricco

Que se passe-t-il avec l’inflation et la productivité dans la zone euro ?

La Banque centrale européenne semble avoir perdu la capacité de relever

l’inflation et les anticipations de prix ont glissé depuis la dernière

récession. Une grande partie du débat politique a porté sur l’aplatissement de

la courbe de Phillips. Pourtant, les estimations du processus conjoint

d’inflation et de production indiquent que les éléments les plus pertinents du

puzzle sont la diminution du potentiel de production et de l’inflation

tendancielle.

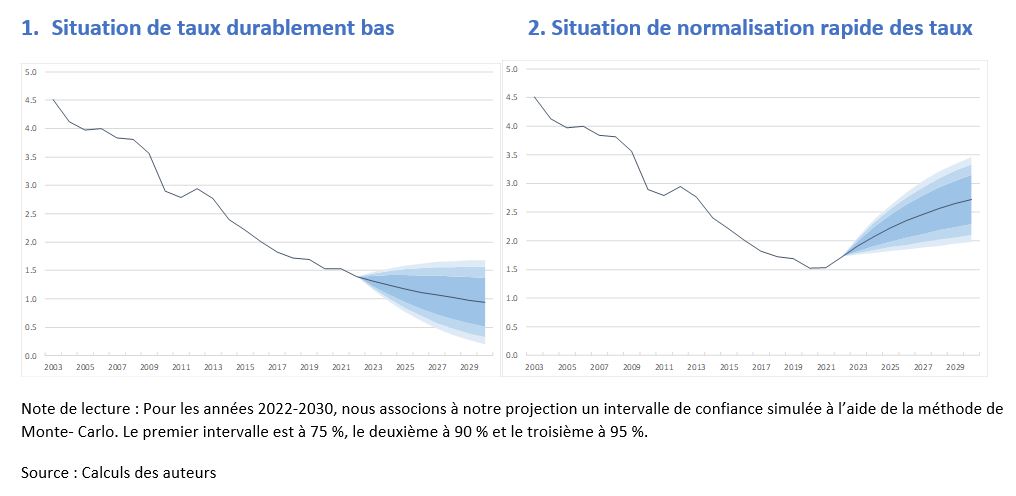

La dernière prévision d’inflation (HICP) de la BCE montre

une révision à la baisse brutale par rapport à ce qui avait été prévu il y a

deux ans (voir BCE, 2017, 2019). Par exemple, l’inflation pour cette année

était estimée à 1,5%, contre 1,2% aujourd’hui. Les chiffres correspondants pour

2020 sont respectivement de 1,7% et 1%.

En janvier 2018, dans notre billet de blog, nous avions

prévu que l’inflation globale de la zone euro serait de 1,1% cette année et

resterait proche de 1% pour les cinq prochaines années. Cette prévision était

basée sur notre modèle semi-structurel d’inflation américaine (Hasenzagl et al., 2018a) adapté aux données de la

zone euro. À l’époque, nous étions beaucoup plus pessimistes que la BCE, mais

conformes aux attentes du marché (Hasenzagl et

al., 2018b).

Dans ce billet, nous posons deux questions. Premièrement,

avec l’avantage de près de deux ans de données supplémentaires, notre vision a-t-elle

changé ? Deuxièmement, qu’implique la réponse pour nos estimations de la

courbe de Phillips et de l’écart de production dans l’Union ?

La réponse à la première question est négative. Nos prévisions pour cette année sont conformes à celles prédites il y a deux ans et indiquent 1,48% pour le T4-2022. Ceci est proche de ce que la BCE prévoit pour 2021.

Pour répondre à la deuxième question, nous pouvons utiliser le modèle pour

obtenir une vue cohérente. En effet, notre modèle produit des estimations d’un

certain nombre des composantes structurelles – production potentielle, écart de

production, loi d’Okun, cycle de prix de l’énergie – et décompose l’inflation

en (i) un cycle expliqué par la courbe de Phillips qui connecte l’écart de

production aux prix, (ii) une composante liée aux prix du pétrole, et (iii) l’inflation

tendancielle identifiée comme une anticipation d’inflation à long terme.

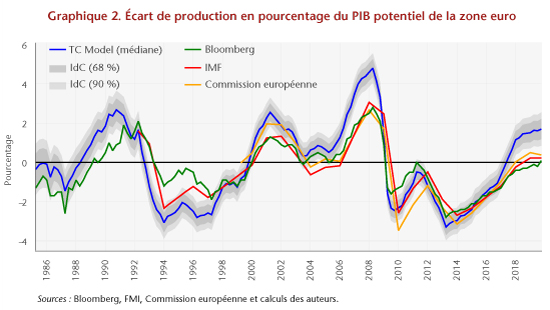

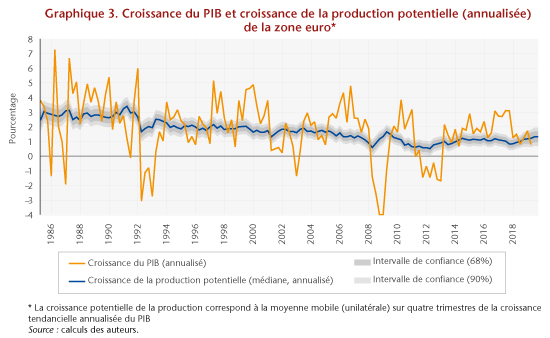

La figure 2 présente notre estimation de l’écart de production par rapport

aux estimations du FMI, de la Commission européenne et de Bloomberg, et la

figure 3 montre notre taux de croissance de la production potentielle.

Notre mesure de l’écart de production est assez corrélée aux mesures

institutionnelles. Cela implique une tendance adaptative qui montre un déclin

constant depuis le début de notre échantillon au milieu des années 1980 et un

ralentissement supplémentaire persistant depuis la grande crise financière (la

croissance potentielle est maintenant estimée à 1%). Celles-ci, en accord avec

l’idée selon laquelle de profondes récessions créent une hystérèse dans l’activité

économique réelle (voir, par exemple, Galì, 2015). Nous attribuons le

ralentissement de la croissance moyenne de la production depuis la crise à la

tendance plutôt qu’au cycle. Cette opinion est également corroborée par

l’observation selon laquelle la récession de 2008 est associée à une baisse

persistante de l’investissement privé, ce qui est en contradiction avec les

régularités du cycle économique précédent (Caruso et al., 2019).

Notre modèle implique une courbe de Phillips relativement pentue par

rapport aux estimations de la littérature selon lesquelles, elle s’est affaiblie

ou a même disparu (voir, par exemple, Ball et Mazumder, 2011 ; FMI, 2013 et

Hall, 2013). Cependant, l’écart de production étant relativement faible et, à

l’heure actuelle, le prix de l’énergie ayant un effet neutre sur l’inflation

globale, la dynamique de l’inflation est expliquée en grande partie par sa

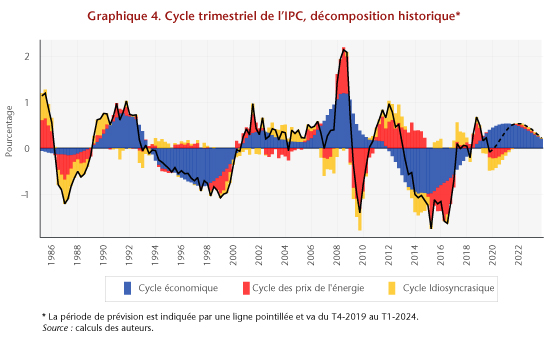

tendance. Le graphique 4 montre la décomposition de la composante cyclique de

l’inflation mesurée par l’IPCH en énergie (en rouge), le cycle économique (en

bleu) et le bruit (en jaune) et fait le bilan.

Cette vision de la dynamique macroéconomique de la zone

euro peut être résumée comme suit.

Nous avons toujours un écart de production positif qui

est proche du sommet (premier trimestre de 2020) et l’économie devrait

maintenant retrouver une croissance tendancielle estimée à environ 1%. La

baisse de l’inflation est principalement imputable à sa composante tendancielle

que nous identifions comme des anticipations de long terme. La courbe de

Phillips, bien que pentue, contribue peu à la hausse car la baisse de la

croissance de la production est due en grande partie à un ajustement à la

baisse du potentiel de production.

Bien que la discussion politique ait principalement porté

sur la courbe de Phillips et le cycle économique, il convient de comprendre les

tendances. Cela est vrai tant pour la production que pour l’inflation.

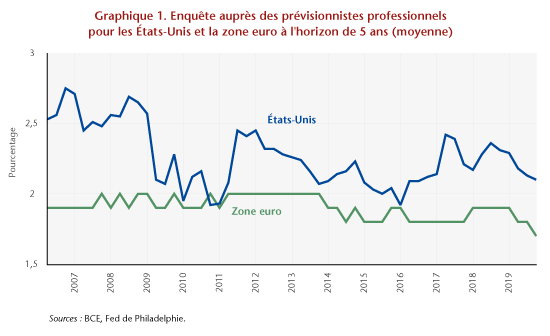

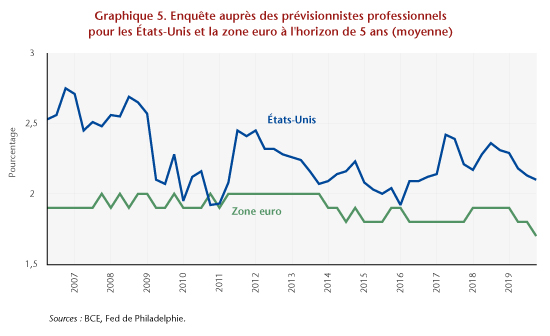

En ce qui concerne les implications politiques, le point

à retenir dans la zone euro devrait être le fait que les anticipations

d’inflation (la tendance) sont en baisse depuis le début de 2014 et que, malgré

une certaine volatilité, elle devrait rester inférieure à l’objectif pendant

longtemps. Le retard de l’action de la politique monétaire en 2012-2014 pourrait

être une explication. Il est intéressant de noter que nos estimations aux

États-Unis indiquent une tendance à la hausse de l’inflation (voir Hasenzagl et al., 2018b). Cette tendance est

également corroborée par la dynamique des anticipations d’inflation sur un

horizon de cinq ans par les prévisionnistes professionnels, illustrée à la

figure 5.

Un objet de réflexion intéressant est la compréhension

des causes communes de la baisse de la croissance de la production tendancielle

et de l’inflation tendancielle. La dette héritée et l’aversion pour le risque,

qui sont la conséquence de la grande crise, ainsi que des incertitudes liées à

une profonde transformation de nos économies, du changement climatique à la

technologie, en passant par le vieillissement, pourraient peser de manière

persistante sur la production et l’inflation. Cela nécessite une politique

monétaire et budgétaire non standard pour faire face aux tendances du PIB

nominal.

Notez également que la même prévision d’inflation aurait

pu être obtenue en appliquant au modèle un écart de production plus important

(et une tendance plus prononcée du PIB) mais une courbe de Phillips plus plate

(voir, par exemple, Jarociński et Lenza, 2018). Par conséquent, la question qui

se pose n’est pas de savoir quelle est la pente de la courbe de Phillips, mais

bien de savoir si nous croyons à un monde caractérisé par une courbe de

Phillips pentue et une croissance de la production potentielle en baisse, ou

dans un monde où la courbe de Phillips est plate et une croissance de la production

potentielle constante.

Ce billet a été publié en anglais sur le site de Vox.eu

Références

Ball, Laurence, et Sandeep

Mazumder, 2011, “Inflation Dynamics and the Great Recession”, Brookings Papers on Economic Activity,

42 (Spring): 337-381.

Caruso, Alberto, Lucrezia Reichlin,

Giovanni Ricco, 2019, “Financial and Fiscal Interaction in the Euro Area

Crisis: This Time was Different”, European

Economic Review, 119: 333-355.

European Central Bank, 2017, “ECB

Staff macroeconomic projections for the euro area”, décembre :

European Central Bank, 2019, “ECB

Staff macroeconomic projections for the euro area”, septembre :

Galí, Jordi, “Hysteresis and the

European unemployment problem revisited”, ECB Forum on Central Banking, mai

2015.

Hall, Robert E., 2013, “The Routes into

and Out of the Zero Lower Bound”, Paper presented at the Global Dimensions of

Unconventional Monetary Policy Federal Reserve Bank of Kansas City Symposium,

Jackson Hole, Wyoming:

Hasenzagl, Thomas, Filippo

Pellegrino, Lucrezia Reichlin, Giovanni Ricco, 2018a, “Low inflation for longer”,

janvier :

Hasenzagl, Thomas, Filippo

Pellegrino, Lucrezia Reichlin, Giovanni Ricco, 2018b, “A Model of the Fed’s View on Inflation”, CEPR Discussion Paper, No. 12564.

IMF, 2013, “The Dog that Didnt

Bark: Has Inflation Been Muzzled or Was It Just Sleeping?” In World Economic Outlook, avril 2013:

Hopes, Realities, Risks. Chapter 3.

Jarociński, Marek et Michele Lenza,

2018, “An Inflation‐Predicting Measure of the Output Gap in the Euro Area,” Journal of Money, Credit and Banking,

Blackwell Publishing, vol. 50(6), pages 1189-1224, septembre.