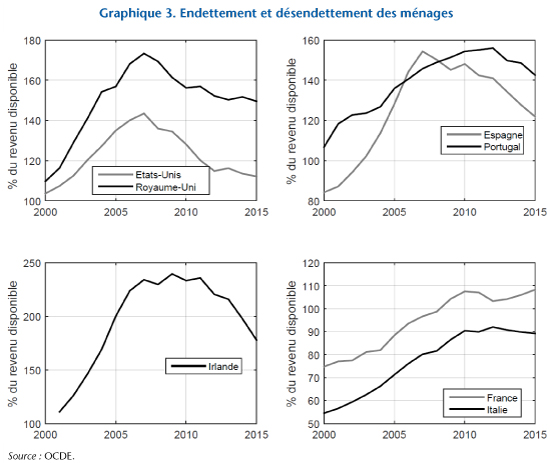

Pourquoi l’inflation européenne est-elle si faible ?

par Stéphane Auray et Edouard Challe

En septembre 2019, la Banque centrale européenne (BCE) annonçait une relance de ses politiques « non conventionnelles », incluant, en sus de l’assouplissement quantitatif (quantitative easing) et des opérations ciblées de refinancement à long terme (targeted long-term refinancing operations, TLTRO), une baisse du taux des facilités de dépôts[i] avec une tranche de monnaie de réserve exonérée des taux négatifs de manière à limiter le coût des réserves pour les banques. Ce nouveau round de politiques accommodantes s’imposait en raison du contexte macroéconomique, marqué par un ralentissement de l’activité en zone euro et un décrochage de l’inflation.

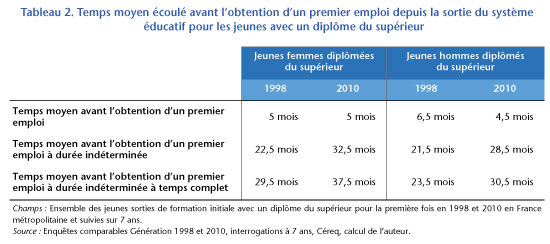

Au début des années 2000, le taux d’inflation oscille autour de 2% et ne connaît que de légères fluctuations jusqu’à 2007 où il atteint son maximum d’avant-crise (voir le graphique 1). Il s’effondre ensuite pendant la « Grande Récession » (2008-2009) puis la crise des dettes souveraines (2011-2013). À ce jour, le taux d’inflation de la zone euro est toujours inférieur à celui d’avant 2008. Au total, entre 1999 (l’année de création de l’euro) et 2019, l’inflation moyenne en zone euro aura été relativement faible (1,7% en moyenne), et tout particulièrement depuis 2009 (1,3% en moyenne). Autrement dit, la BCE ne semble pas avoir atteint son objectif, explicité dès 2003, d’un taux d’inflation des prix à la consommation « inférieur à, mais proche de, 2 % ». Pourquoi cela ?

D’après la théorie économique, la

faiblesse de l’inflation reflète celle des coûts de production, et donc de la

demande agrégée : un niveau de demande faible se traduit par une moindre

tension sur les facteurs de production (travail, capital, énergie, matières

premières, …) et donc, toutes choses égales par ailleurs, une moindre croissance

de leurs prix. La pression concurrentielle conduit alors les entreprises à

répercuter ces faibles coûts sur leurs prix de vente, ce qui engendre une

désinflation des prix. À l’inverse, une expansion économique engendre

mécaniquement des tensions sur les facteurs de production et donc une hausse de

leur coût, laquelle est répercutée sur les prix de vente des entreprises et

fait monter le niveau général des prix. C’est la logique de de la « courbe

de Phillips », qui constitue l’un des blocs fondamentaux de la

macroéconomie monétaire depuis les années 1960.

Ainsi, lorsque la banque centrale perd le contrôle de l’inflation, c’est

avant tout parce qu’elle a perdu le contrôle de la demande agrégée. De ce point

de vue, les pressions déflationnistes en zone euro ne sont que le reflet de

l’incapacité de la BCE à relancer suffisamment la demande.

Une explication alternative (et plausible)

à la faiblesse de l’inflation est que la BCE parvient à stimuler la demande par

ses politiques accommodantes, mais que la répercussion des variations de la

demande sur les coûts de production, et donc en définitive sur le niveau

général des prix et l’inflation, serait plus faible que par le passé – voire

aurait complètement disparu. Selon les partisans de cette théorie, la « pente

de la courbe de Phillips » serait devenue proche de zéro en zone euro, ce

qui expliquerait la perte de contrôle de l’inflation par la BCE. S’il fait

certes peu de doute que la pente de la courbe de Phillips s’est réduite aux États-Unis

depuis les années 1980, des

travaux empiriques récents conduisent néanmoins à nuancer le constat de

la « mort » de la courbe de Phillips, tant aux États-Unis qu’en zone euro. Une

autre caractéristique de la courbe de Phillips, indépendante de sa pente,

pourrait également expliquer la faiblesse de l’inflation européenne : on

sait depuis la conférence

présidentielle de Milton Friedman au congrès de 1967 de l’American Economic Assocation que la courbe de Phillips fait intervenir l’inflation

anticipée, en sus des tensions sur

les coûts de production, comme déterminant de l’inflation réalisée. Donc si

l’inflation anticipée décroche de sa cible alors elle tire vers le bas

l’inflation réalisée, indépendamment

du niveau de la demande. Cette inquiétude est légitime mais elle soulève deux

questions. Tout d’abord, les prévisionnistes

professionnels régulièrement interrogés par la BCE prévoient une lente remontée

de l’inflation à l’horizon 2025 ; le décrochage des anticipations

d’inflation ne saute donc pas aux yeux. Ensuite, si la pente de la courbe de

Phillips n’est pas nulle, l’effet d’un décrochage des anticipations d’inflation

sur l’inflation réalisée devrait pouvoir être compensé par une relance

suffisamment prononcée de la demande.

Enfin, indépendamment des discussions

autour de la forme de la courbe de Phillips, certains commentateurs avancent

parfois des raisons « structurelles » aux pressions déflationnistes

de la dernière décennie, plutôt que de l’attribuer à la faiblesse de la demande,

ou à la moindre transmission des tensions sur la demande aux coûts. Selon cette

théorie, la pression concurrentielle à laquelle sont soumises les entreprises

se serait intensifiée, notamment en raison de l’ouverture au commerce

international et des nouvelles technologies. Cette concurrence accrue forcerait

les entreprises européennes (et mondiales) à comprimer leurs marges, ce qui

exercerait une pression baissière permanente sur les prix. Ces mécanismes ne

peuvent pourtant pas expliquer la faiblesse de l’inflation en zone euro. En

effet, le prix de vente d’une entreprise est (tautologiquement) le coût

unitaire de production multiplié par le facteur de marge. La pression concurrentielle

peut certes faire baisser le facteur de marge, mais cela ne peut être que très

progressif, et surtout transitoire puisque

le facteur de marge ne peut tomber en dessous de 1 (sans quoi le prix de vente

serait inférieur au coût unitaire de production et l’entreprise aurait intérêt

à fermer). Enfin, et c’est là le plus important, cette baisse graduelle du

facteur de marge devrait pouvoir être compensée par une variation du coût

unitaire de production, dont on vient de voir qu’il dépendait de la demande

agrégée. Ainsi, une banque centrale ciblant un certain niveau d’inflation (ce

qui est le cas de la BCE, ainsi que de la majorité des grandes banques

centrales) devrait en principe pouvoir annuler tout effet de la baisse

tendancielle des marges sur les prix en stimulant suffisamment la demande

agrégée. Tout ceci nous ramène au point de départ : pour comprendre

l’excès de déflation (ou du moins de désinflation) en zone euro, il nous faut

comprendre pourquoi la demande agrégée y est trop faible, et pourquoi la BCE ne

parvient pas à la relancer.

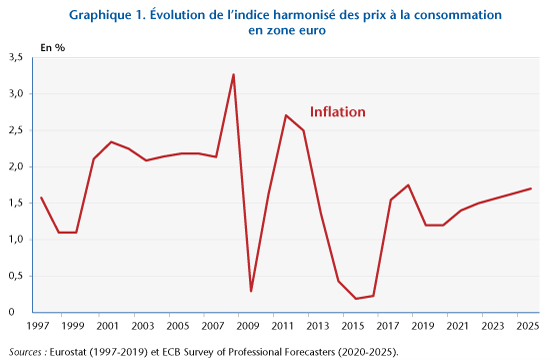

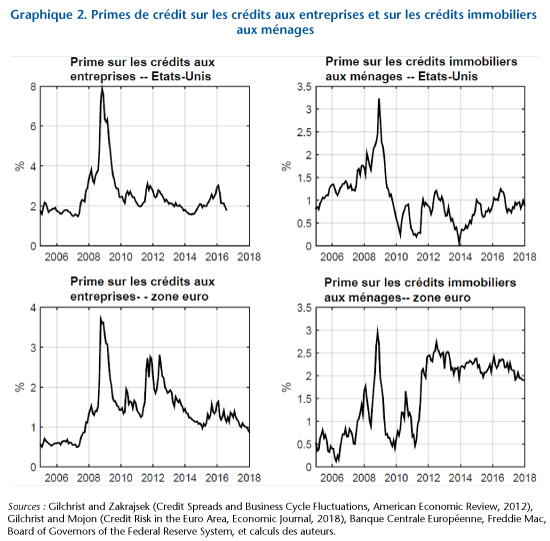

L’origine de la crise économique qui a frappé l’économie mondiale à partir de 2008 est aujourd’hui assez bien comprise. Au départ, un choc financier de grande ampleur a provoqué une explosion des primes de crédit (voir graphique 2), accompagnée, dans un certain nombre de pays, d’une phase de désendettement des ménages (graphique 3). La hausse des primes de crédit limite l’activité des emprunteurs risqués (ménages et entreprises), et le désendettement des ménages freine mécaniquement et durablement leur demande de consommation, tant en biens durables qu’en biens non durables. Par ailleurs, en zone euro, le choc initial de 2008-2009 a été prolongé par la crise des dettes souveraines, laquelle a provoqué une retombée en récession à partir de 2011. Sans remèdes adéquats, les chocs de demande négatifs de ce type ont tendance à s’amplifier d’eux-mêmes car ils font augmenter le chômage, ce qui fait baisser le revenu, la demande de consommation, et ainsi de suite – selon la logique du fameux « multiplicateur keynésien ». Ce faisant, ces chocs entraînent une pression baissière durable sur la production et sur l’inflation.

Selon la théorie (et la pratique) de la politique monétaire conventionnelle, il est à la fois souhaitable et possible de contrer efficacement de tels chocs de demande négatifs : il suffit que la banque centrale ajuste sa « posture » (stance) en penchant de manière suffisamment prononcée contre le vent de la déflation (en baissant ses taux directeurs, qui sont des taux d’intérêt nominaux à court terme). La banque centrale doit alors être suffisamment « réactive » : elle doit faire varier ses taux directeurs (qui sont des taux d’intérêt nominaux) plus de un pour un en réponse aux variations du taux d’inflation, de sorte que le taux d’intérêt réel (c’est-à-dire le taux d’intérêt nominal moins l’inflation) chute lorsque l’inflation baisse, et inversement. C’est seulement sous cette condition que la banque centrale peut stimuler la demande agrégée et donc relever le taux d’inflation à la suite d’un choc de demande négatif (et inversement comprimer la demande lorsque l’inflation est trop élevée). La BCE s’est précisément engagée dans cette politique conventionnelle au début de la crise, en baissant ses différents taux directeurs de plus de 300 points de base en moins d’un an à partir de l’été 2008 ; puis de nouveau à partir de 2009, pour finalement atteindre un taux de 0% sur les opérations principales de refinancement (et -0,5% sur les réserves excédentaires, hors exemption, depuis septembre dernier).

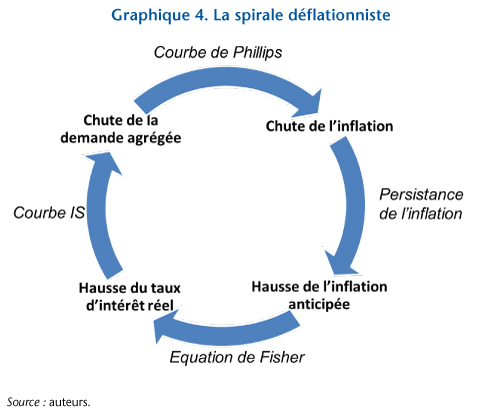

Une fois ce stade atteint, il devient risqué de s’engager en territoire négatif de manière encore plus agressive, notamment en baissant davantage le taux d’intérêt sur les réserves excédentaires, car les banques pourraient en principe massivement demander à la banque centrale la conversion de leur monnaie de réserve (qui est électronique et inscrite au compte de la banque auprès de la banque centrale) en billets de banques physiques, dont la rentabilité nominale est de… 0% ! Rappelons simplement ici qu’un billet ne change pas de valeur nominale au cours du temps. Ainsi, une fois atteinte la « borne zéro » sur les taux d’intérêt, la banque centrale devient « passive » et non plus active car ses taux d’intérêt directeurs (collés à zéro, ou à des valeurs proches de zéro) ne peuvent plus répondre de manière suffisamment prononcée aux variations de l’inflation autour de sa cible. Un cercle vicieux se met alors en place, qui tend à entretenir la faiblesse de la demande agrégée et de l’inflation (cf. graphique 4) : comme le taux d’intérêt nominal ne baisse plus suffisamment à la suite des pressions déflationnistes, celles-ci engendrent une hausse du taux d’intérêt réel (d’après la relation de Fisher), laquelle affaiblit encore plus la demande agrégée (selon logique de la courbe IS). La baisse de la demande renforce les pressions déflationnistes initiales (en raison de la courbe de Phillips), ce qui conduit les agents économiques à anticiper une inflation faible, élève encore davantage le taux d’intérêt réel, et ainsi de suite. C’est pourquoi il est si difficile de redresser l’inflation et ses anticipations dans cette configuration macroéconomique, qui est celle dans laquelle se débat la zone euro depuis déjà un certain nombre d’années. Si les différentes politiques non conventionnelles mises en œuvres par la BCE ont permis de limiter la spirale déflationniste, elles n’ont pu totalement en éliminer les effets.

[i] La

Banque centrale européenne a trois taux directeurs officiels : (i) le taux

sur la facilité de dépôt, auquel est rémunérée la monnaie de réserve excédentaire

que les banque détiennent sur leur compte auprès de la banque centrale ;

(ii) le taux

sur les opérations principales de refinancement, auquel se refinancent les

banques, contre collatéral, à échéance d’une semaine; et (iii) le taux

d’intérêt sur les prêts marginaux, qui est le taux débiteur auquel les

banque peuvent emprunter en urgence et au jour le jour auprès de la BCE.