Jean-Paul Fitoussi, dont les très grandes qualités scientifiques, pédagogiques et humaines sont unanimement louées, avait, à la place qui était la sienne dans l’académie et dans la société, le souci permanent des souffrances sociales liées au chômage et à la pauvreté, la volonté de contribuer à les combattre en faisant usage de l’arme de la théorie et de la politique économiques, la conviction que la démocratie était seule la forme politique à même d’assurer les régulations nécessaires. L’objet de ce qui suit, témoignage de cinquante-quatre ans de complicité et d’amitié, est, sur la base d’une lecture chronologique, de souligner l’unité et la continuité de la démarche scientifique adoptée et défendue par celui qui, en un demi-siècle de carrière, s’est voulu un lutteur intellectuel ancré dans son époque, informé des affaires du monde et surtout de l’Europe, conformément à l’image qu’il avait de Keynes dont il voulait conserver et développer le message.

(i)

Il est une mise en garde qui parcourt toute l’œuvre de Jean-Paul Fitoussi, celle à l’encontre des effets inévitablement néfastes du chômage comme de l’inflation qui pèsent sur les plus fragiles, renforce les inégalités et menace la soutenabilité de la croissance. Ce discours de dimension sociale et politique s’appuie sur une analyse économique rigoureuse qui s’inscrit dans les pas des plus grands économistes, notamment dans ceux de Keynes.

Le jugement porté par Jean-Paul Fitoussi sur le capitalisme est précisément le même que celui de Keynes : il y voit un système instable mais possiblement viable pourvu que soit reconnue l’importance d’une régulation extérieure au marché, produit du débat et des choix démocratiques. Sa vision renouvelée de ce qui fait l’essence de la pensée de Keynes irrigue la compréhension qu’il a des événements du dernier demi-siècle. Elle explique son attachement à la construction européenne en même temps que sa critique de la manière dont elle est conduite.

S’en tenir à voir dans ses réflexions et analyses la marque d’observations perspicaces de la réalité pouvant servir de repères au théoricien et à l’économètre serait à n’en pas douter ignorer la profondeur de sa démarche proprement théorique. Que celle-ci n’emprunte pas les sentiers convenus de la théorie économique « moderne » ne la disqualifie nullement, bien au contraire. Sa caractéristique première est d’identifier les problèmes avant de définir la méthode appropriée pour en traiter, ce qu’il appellera placer le lampadaire au bon endroit pour voir les nouveautés plutôt que de s’engager dans une course à l’élaboration d’une théorie pure (Fitoussi 2013). Comme on le verra, mettre l’accent sur les déséquilibres propres à l’évolution des économies de marché ne pouvait que conduire Jean-Paul Fitoussi à s’écarter de la méthode de l’équilibre. La difficulté à laquelle il se heurtera est l’interdit opposé à tout débat à la fois théorique et politique qui remettrait en cause cette méthode (Fitoussi 1995, 2013).

Deux fils conducteurs ont toujours structuré son raisonnement analytique. Les phénomènes globaux sont le reflet de l’hétérogénéité persistante ou accrue des marchés, des revenus et des pays. Ces phénomènes rendent compte d’une étroite interdépendance entre ce qu’il est convenu d’appeler le secteur « réel » de l’économie et le secteur monétaire et financier.

À ceux qui doutent de la dimension d’abord théorique des travaux de Jean-Paul Fitoussi, il faut rappeler que ce qui est à l’origine de sa démarche est une compréhension fine de la théorie de l’équilibre général qu’il tire de ses relations avec Kenneth Arrow, Nicholas Georgescu-Roegen et Axel Leijonhufvud. Elle le conduit à rappeler les conditions fortement restrictives qui président à l’existence d’un tel équilibre, conditions qu’ignore la théorie macroéconomique « moderne », une théorie qui s’en tient à faire de la flexibilité des prix et des salaires l’outil essentiel de la réalisation d’un optimum social, une théorie suivant laquelle le chômage est volontaire, l’inflation rationnellement anticipée, et les marchés financiers absents, et une théorie qui recommande la neutralité de la monnaie et du budget.

Fort cette connaissance du modèle de référence, Jean-Paul Fitoussi va, au fil de ses recherches, contester la pertinence de la macroéconomie dite de la nouvelle école classique comme d’ailleurs de la nouvelle école keynésienne pour mettre l’accent sur les problèmes de coordination qui naissent d’une incertitude radicale, que ne peut résoudre à lui seul le système des prix et qu’il s’agit avant toute chose d’identifier. Il emprunte à Clower (1965) et Leijonhufvud (1968) leur lecture de Keynes impliquant d’étudier les canaux de prix et de quantités au moyen desquels circule une information nécessairement imparfaite et incomplète entre des agents multiples. Non seulement la monnaie n’est pas absente de ces canaux, mais elle ne peut pas être neutre. Il n’existe pas d’économie du déséquilibre ou hors de l’équilibre qui ne soit pas une économie monétaire et même suivant l’expression de Keynes que reprend Fitoussi une économie monétaire de production. Si débat interdit il y a, c’est bien d’un débat théorique dont il s’agit (Fitoussi 1995).

(ii)

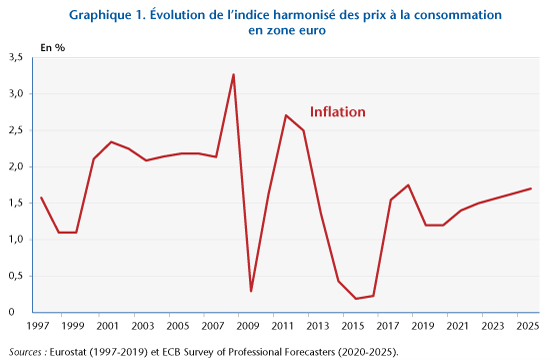

La toute première contribution de Jean-Paul Fitoussi – sa thèse de doctorat d’État de sciences économiques, Inflation, équilibre et chômage, soutenue en 1971 à l’Université Louis Pasteur de Strasbourg et publiée en 1973 – suit déjà les principes de cette démarche. Elle porte sur les relations entre inflation et chômage et donne une explication de phénomène de stagflation radicalement opposée à celle proposée par les monétaristes. Elle fait valoir l’existence et l’importance de fondements microéconomiques de la macroéconomie. L’idée empruntée à différentes contributions d’un ouvrage collectif édité par Edmund Phelps (1970) est qu’en présence de déséquilibres de marché, entre demande et offre, les prix et les salaires sont plus flexibles à la hausse qu’à la baisse (et donc les quantités y compris l’emploi sont plus flexibles à la baisse qu’à la hausse) de telle sorte qu’une dispersion accrue des demandes excédentaires nettes entraîne une hausse conjointe du taux d’inflation et du taux de chômage, autrement dit une stagflation. Cette explication concorde avec les faits observés dans les années 1970 au cours desquelles des chocs de nature diverse sur les prix des matières premières ont affecté la structure sectorielle de l’économie. Elle n’a nul besoin de se rapporter à l’existence d’un taux de chômage naturel et se sépare de toute idée de dichotomie entre secteur réel et secteur monétaire de l’économie. Elle est formulée un peu plus tard dans des termes voisins par Tobin (1972, 1995). Bien que généralement ignorée, elle est, aujourd’hui, d’une singulière actualité dans des économies confrontées à des chocs sanitaires, technologiques et géopolitiques qui ont engendré une forte hausse des prix des matières premières dont la diffusion en aval devrait entraîner des bouleversements dans la structure des économies.

La pertinence de la théorie ainsi formulée tient au caractère récurrent de situations de marché contrastées qu’explique le fait que le capitalisme est en perpétuel état de mouvement, un flux permanent de nouveautés venant rompre les équilibres existants conformément à l’analyse de Schumpeter. En l’occurrence l’asymétrie des variations de prix (à laquelle s’ajoute l’asymétrie entre accumulation de décumulation du capital) peut avoir pour corollaire un affaiblissement du taux de croissance (Fitoussi et Georgescu-Roegen 1980). En fait, il est possible d’imaginer une économie au sein de laquelle persistent des déséquilibres sectoriels sans qu’il y ait aggravation de ces derniers auquel cas le taux de croissance, quoiqu’approximativement constant est plus faible que s’il y avait parfaite coordination.

(iii)

Son explication du phénomène de stagflation, qui se présente comme l’alternative keynésienne à la thèse monétariste, conduit naturellement Jean-Paul Fitoussi à inscrire sa démarche dans le débat initié par Clower (1965) et Leijonhufvud (1968, 1973) visant à proposer une nouvelle lecture de Keynes. Dans sa thèse complémentaire soutenue en 1973, intitulée Le fondement microéconomique de la théorie keynésienne et publiée en 1974, il distingue clairement la théorie de Keynes d’une théorie de Walras. Elles ont certes en commun de considérer l’interdépendance des marchés. Mais celle de Keynes met en avant l’importance du revenu dans le mécanisme de l’échange du fait d’une information imparfaite et reconnaît à la monnaie une fonction essentielle. Alors que celle de Walras conserve au système de prix un rôle déterminant dans un univers où la monnaie n’a pas véritablement d’utilité. Jean-Paul Fitoussi entend, alors, compléter la théorie de Keynes en explicitant son fondement microéconomique lequel repose la structure des agrégats, et prend comme exemple l’effet de changements dans la répartition des revenus sur la consommation globale.

Par la suite, partie prenante des développements de la macroéconomie autour de ce qu’il était convenu d’appeler la théorie des déséquilibres (Vélupillaï 2012), Jean-Paul Fitoussi se sépare des modèles de la théorie des équilibres généraux à prix fixes. Distinguant l’équilibre virtuel de Walras de l’équilibre signalé de Keynes, il refuse de parler d’équilibre général dès lors que ce qui est signalé (ou anticipé) n’est pas réalisé. À moins que tous les ajustements ne soient effectués à prix fixes ce qu’il juge aussi improbable que des ajustements par les prix (Fitoussi 1983). Il ne juge pas crédible une coordination par les quantités qui viendrait se substituer à une coordination par les prix. Ce faisant, il distingue une coordination en déséquilibre d’une coordination sur un équilibre particulier. Il reconnaît l’existence de plusieurs concepts d’équilibre – chômage keynésien, chômage classique, inflation réprimée – mais il souligne que ce qui les différencie n’a rien à voir avec le problème de coordination – tous les modèles étant fondés sur l’existence d’un mécanisme de tâtonnement – mais tient au type de contraintes qui apparaît dans la résolution des problèmes d’optimisation individuelle. Or pour lui, s’il doit y avoir un fondement microéconomique à la théorie macroéconomique, celui-ci ne réside pas dans le comportement d’optimisation d’agents individuels confrontés à des contraintes exogènes, mais dans l’interaction entre des agents aux comportements différenciés en raison de la nature des déséquilibres auxquels ils sont confrontés.

(iv)

Au cours de l’étape suivante, Jean-Paul Fitoussi a fait porter son attention sur la coordination des plans intertemporels des agents, autrement dit sur la place et le rôle du taux d’intérêt dans une période qui allait être marquée par des politiques monétaires restrictives et des taux d’intérêt réels particulièrement élevés modifiant les rapports de force entre créanciers et débiteurs dont les relations sont l’une des caractéristiques structurelles de l’économie. Pour Jean-Paul Fitoussi c’était l’occasion de souligner avec force l’impossible neutralité de la monnaie et de la finance et d’engager un débat de politique économique au cœur de la question européenne.

L’idée récurrente empruntée à Keynes – à la lecture qu’en fait Leijonhufvud (1968, 1981) – est que le chômage est la conséquence, non d’une rigidité des salaires, mais de la défaillance du taux d’intérêt à coordonner efficacement les plans d’épargne et d’investissement (Fitoussi et Leijonhufvud 2002). S’agissant, chez Keynes, d’expliquer la Grande Dépression, l’argument que retient Lejonhufvud (1981) dans sa propre lecture est qu’à la suite d’une chute de l’efficacité marginale du capital (du taux de profit), le taux d’intérêt ne diminue pas comme le prévoit la théorie néo-classique des fonds prêtables du fait du comportement des détenteurs de capitaux qui anticipent une baisse des prix des titres, autrement dit une hausse des taux d’intérêt. Jean-Paul Fitoussi s’intéresse à une situation quelque peu différente, celle née de la forte inflation des années 1970 qui s’est traduite par la mise en œuvre de politiques monétaires très restrictives et une hausse des taux d’intérêt réels aux effets négatifs sur l’emploi.

Dans le contexte des années 1980, l’un des enjeux de théorie et de politique économiques était d’expliquer les écarts de performances entre les États-Unis et l’Europe. L’analyse alors retenue par Jean-Paul Fitoussi est que la hausse des taux d’intérêt réels (importée des États-Unis), entendue comme une dépréciation de l’avenir, associée à la variation du taux de change a des effets asymétriques sur les comportements de marge aussi bien que d’investissement des entreprises de part et d’autre de l’Atlantique (Fitoussi et Phelps 1988). Il s’ensuit un défaut de convergence qui contredit la théorie standard de la transmission des déséquilibres. L’analyse de l’étroite dépendance entre les taux d’intérêt et l’emploi fait ici peu de place au rôle des marchés financiers pour s’en tenir à celui des politiques monétaires et budgétaires. Phelps, pour sa part, parle de causes non monétaires de l’emploi quand il insiste sur l’importance des marchés de biens dits marchés de clientèle, autrement dit de marchés imparfaits. Jean-Paul Fitoussi reconnaitra plus tard avoir mésestimé l’affaissement de l’économie américaine faute d’en avoir perçu les prémisses (Fitoussi in Laurent et Le Cacheux 2015).

Par la suite, dans une analyse quelque peu différente, Jean-Paul Fitoussi, renouant avec la perspective ouverte par Keynes, retient comme cause du chômage l’effet qu’exerce sur l’économie « réelle » l’augmentation des taux d’intérêt réels remettant en cause l’efficience des marchés financiers (Fitoussi 1995). Une première conséquence de cette hausse est une augmentation des revenus du capital beaucoup plus forte que celle des revenus du travail impliquant une chute de la part des salaires dans le revenu global. Une deuxième conséquence est de créer un déficit du système de sécurité sociale financé par des prélèvements fiscaux sur le travail. Ce qu’il advient de l’économie globale procède de la dépréciation du futur entrainant la modification des relations de pouvoir au bénéfice des créanciers et au détriment des débiteurs. Dans ce contexte, chacun, employeur ou travailleur, cherche à tirer le meilleur parti de relations qu’ils prévoient être de courte durée. La théorie de la productivité marginale devient une fiction. Des marchés financiers inefficients, dominés par les créanciers, exercent leur tutelle sur des politiques économiques qui deviennent assez systématiquement restrictives.

(v)

Les déséquilibres propres aux économies européennes engagées dans un processus d’unification sont, pour Jean-Paul Fitoussi, un champ privilégié d’observation et d’analyse, Ils ont inévitablement une dimension politique. Dans Le débat interdit (1995), il maintient que la cause principale du ralentissement de l’activité économique en Europe est la hausse excessive des taux d’intérêt qui entraîne un creusement du déficit budgétaire. Le point important de son analyse est, cependant, de dénoncer l’erreur des pays européens qui ont laissé se développer le conflit d’intérêt entre l’Allemagne en voie de réunification et le reste de l’Europe. Concrètement, pour lui, il eut fallu éviter à l’Allemagne de supporter tout le coût de sa réunification dont la conséquence a été une forte hausse de son taux d’intérêt qui s’est généralisée à l’ensemble des pays européens. Il aurait mieux valu échanger une baisse des taux d’intérêt contre une participation à la reconstruction. Ce conseil (rétrospectif) de politique économique repose sur une théorie macroéconomique qui fait place à l’hétérogénéité des situations nationales et ne retient pas comme vérité une convergence des performances qui résulterait de l’application de règle simples de neutralité monétaire et budgétaire. Ce disant Jean-Paul Fitoussi se situe dans la droite ligne des principes d’analyse économique retenus dès le début de son parcours scientifique. Il n’existe pas de performance globale qui ne soit assise sur des effets de structure associés à des déséquilibres.

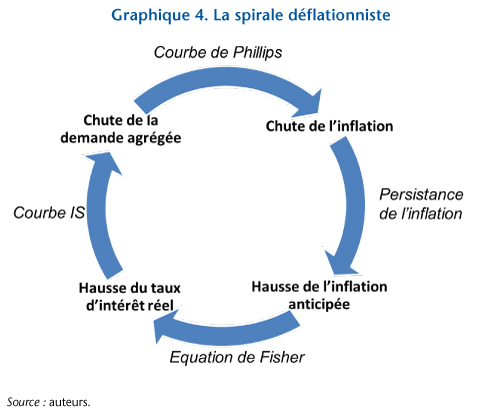

Jean-Paul Fitoussi met plus largement en cause un mode de gouvernance qu’il rend responsable des divergences de performances entre les pays de l’Union Européenne (Fitoussi 2002, Fitoussi, Gaffard et Saraceno 2010, Fitoussi 2013, Fitoussi et Saraceno 2013). Ce mode de gouvernance, au cours de la période concernée, est articulé autour d’une politique monétaire dédiée à contrôler l’inflation, d’une politique budgétaire contrainte par des objectifs de déficit public et de dette publique, et d’une politique de la concurrence visant à ouvrir et libéraliser les marchés. Il répond à une norme sociale qui n’est autre que l’acceptabilité de comportements présumés vertueux dont l’objet est de garantir la réputation des gouvernements qui s’y réfèrent (Fitoussi 2005). La mise en œuvre de ce qui apparaît comme un consensus n’a pas permis la convergence attendue des performances à l’exception de celle des taux d’inflation. Le défaut de cette stratégie est de faire la promotion d’une taille unique qui ne va à personne consistant imposer des réformes dites structurelles visant à la flexibilité des prix et des salaires et à mettre l’accent exclusivement sur l’offre au détriment d’une attention portée sur les déséquilibres et l’articulation entre offre et demande. Les coûts éventuels de ces réformes sont généralement sous-estimés, le problème n’étant pas tant le montant des transferts de compensation que le déclenchement de mécanismes cumulatifs créant notamment des formes de dualisme dans la société dès lors que l’économie est déjà dans une mauvaise passe. La justesse du diagnostic ainsi formulé, qui s’appuie, ne serait-ce qu’implicitement sur l’importance de différentes formes d’hétérogénéité, est, certes, attestée par l’échec de l’objectif général de stabilisation automatique et de convergence, mais aussi par l’irruption contrainte des mesures qualifiées élégamment de non conventionnelles pour faire face aux crises. La solution des difficultés nées du mode gouvernance ne peut qu’être un renoncement à des réformes structurelles entièrement dédiées à une action sur l’offre et l’adoption de politiques structurelles ayant pour objet d’adapter l’offre à la demande pour répondre aux déséquilibres inhérents au développement.

(vi)

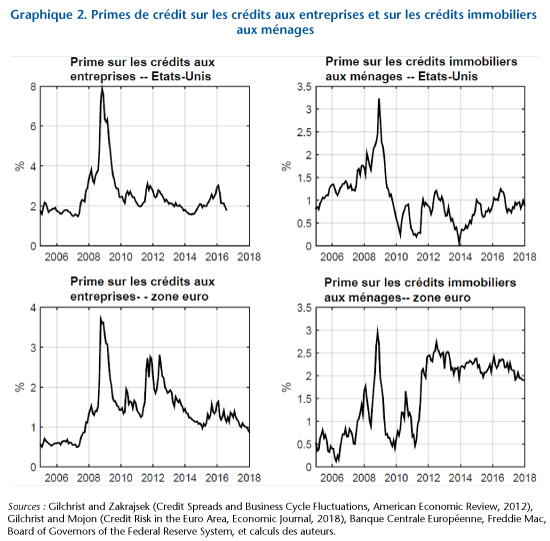

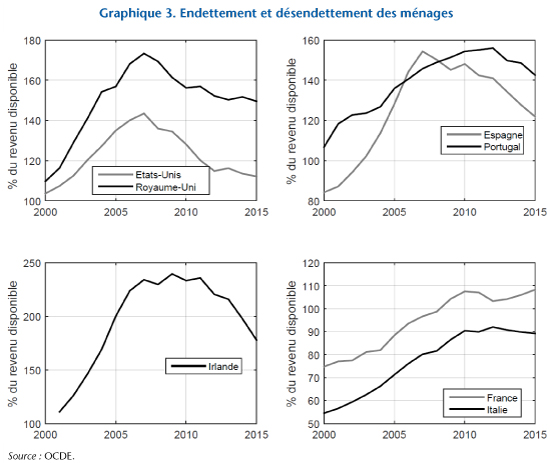

Très vite, Jean-Paul Fitoussi s’inquiète de l’aggravation des inégalités qui accompagne les politiques mises en œuvre, dénonce la mise en panne des institutions pourvoyeuses de lien social et de solidarité, et avertit du risque de montée en puissance de populismes pervers (Fitoussi et Rosanvallon 1996). Pour lui, les inégalités sont, non seulement, inacceptables socialement, mais elles sont source d’instabilité. Si on le suit, la crise de 2008 n’est pas simplement financière (Fitoussi et alii 2010, Fitoussi et Saraceno 2010). Elle résulte de déséquilibres sous-jacents de long terme qui mêlent de manière inextricable phénomènes réels et financiers. L’un de ces déséquilibres tient à la montée continue des inégalités qui aggrave l’instabilité macroéconomique suivant différents canaux. La faible croissance des revenus en milieu et en bas de la distribution associée à l’insuffisance de l’augmentation des salaires réels et de la création d’emplois a incité au laxisme de la politique monétaire constant à maintenir au plus bas les taux d’intérêt. La stagnation des revenus a entraîné un endettement insoutenable des ménages les moins riches. Dans le même temps, la hausse des revenus des plus riches a engendré des pratiques qui ont nourri les bulles immobilières et de crédit. L’idée de base est que les propensions à consommer sont différentes suivant la classe de revenus et que le creusement des inégalités a des effets sur la demande globale en même temps que sur les situations d’endettement des uns ou d’enrichissement des autres. Les changements intervenus dans la structure des revenus sont répercutés sur la structure de la demande et sur les structures financières au détriment d’un usage productif des ressources. La crise qualifiée de financière a ses racines dans l’enchaînement de déséquilibres au cœur desquels se trouve une aggravation des inégalités qui tient pour partie à des choix de politique économique et notamment à des choix fiscaux qui avaient en ligne de mire des effets de ruissellement qui n’ont jamais existé.

(vii)

Une théorie macroéconomique qui met en scène des interactions dans des situations de déséquilibre dans une économie où monnaie et finance ne sont pas neutres ne pouvait que déboucher sur une théorie de la politique économique elle-même en rupture avec le courant dominant. L’Union Européenne constitue de nouveau le lieu du débat. Pour Jean-Paul Fitoussi, il s’agit d’abord de qualifier la pratique des institutions européennes qu’il décrit comme étant composées d’un ministre de la stabilité des prix (la Banque centrale), d’un ministre de la surveillance budgétaire et d’un ministre de la concurrence, chacun devant agir en suivant des règles établies par les traités. Ces règles se substituent à des choix discrétionnaires ou si l’on préfère à des arbitrages entre objectifs (Fitoussi 2002). La prise de position en faveur de politiques économiques dictées par des choix discrétionnaires ne saurait être ramenée à un plaidoyer en faveur d’un arbitrage entre inflation et chômage le long d’une courbe de Phillips présumée stable d’autant que l’analyse structurelle de cette relation (Fitoussi 1973) concluait à la possible instabilité de cette relation. Ce qu’entend dire plus largement Jean-Paul Fitoussi c’est qu’avec un modèle non linéaire (qui décrit des interactions hors de l’équilibre) il n’est pas possible de spécialiser les instruments de politique économique, de dédier un seul instrument à un seul objectif impliquant d’établir une règle pour chaque sujet. Il convient, au contraire, de reconnaître non seulement la multiplicité des instruments et des objectifs, mais aussi la nécessité de mobiliser plusieurs politiques pour un même objectif. Cette position théorique ne peut qu’éclairer les renoncements aux règles provoqués par les crises récentes que ne pouvait en rien expliquer ni résoudre la théorie en place.

(viii)

Le problème se pose des conditions institutionnelles des choix à effectuer. Il s’agit alors pour Jean-Paul Fitoussi de s’interroger sur les relations entre la démocratie et le marché (Fitoussi 2004). Il ne peut y avoir de théorie pure. L’économie est politique. En fait, la théorie prétendument pure s’accommode du déni de démocratie. Les experts, mieux informés et plus compétents, auraient à décider des règles dont la définition échapperait aux aléas de l’élection. Cette doctrine est celle du dictateur bienveillant. Son principal défaut est, de manière plus ou moins explicite, de négliger, non seulement, la question de l’information, de sa disponibilité et de sa distribution, mais aussi et surtout l’instabilité inhérente à la récurrence des déséquilibres. Comme le souligne Fitoussi (ibid.), le marché parfait ne correspond à aucune forme politique alors que des marchés imparfaits ou incomplets excluent un gouvernement qui se réfugierait dans l’abstention. Cette complémentarité peut être appréciée de deux façons distinctes. Soit il est question de réduire autant que se peut l’espace de la décision publique perçue comme un mal nécessaire. Soit il est question de répondre aux risques de l’instabilité en créant les conditions institutionnelles d’un arbitrage efficace. Pour Jean-Paul Fitoussi, ces conditions sont celles de la démocratie. C’est elle qui permet de mieux maîtriser les chocs, de lisser les fluctuations, de réduire les coûts sociaux du changement, parce qu’elle est une forme flexible de gouvernement, parce que face aux erreurs et aux échecs elle permet de s’adapter au lieu de persister à appliquer la même doctrine comme s’il n’y avait pas d’alternative. La complémentarité revendiquée est entre la démocratie et le marché au sens où système politique et système économique se confortent mutuellement. Le paradoxe apparent est que les choix en démocratie en tant qu’ils résultent d’arbitrages sont limités alors que le choix du dictateur bienveillant est sans limite.

(ix)

La quête d’une politique économique à la fois juste et efficace ne pouvait que conduire Jean-Paul Fitoussi à réfléchir sur les indicateurs qui devrait la guider et à aborder la question de la mesure du bien-être indissociable de celle de la soutenabilité de l’évolution (Stiglitz, Sen et Fitoussi 2009). Sans doute l’un des points saillants de la démarche est-il d’avoir souligné l’importance des changements structurels dans la mesure des performances, qu’il s’agisse de changements des parts respectives de la production marchande et de la production publique, de changements dans la répartition des revenus ou de changements dans la part du revenu revenant à au secteur financier. Faute de prendre en considération ces changements, il ne sera pas possible de percevoir les conditions de soutenabilité à moyen et long terme. La soutenabilité dont il est question reste celle de la croissance, non pas que le contenu de cette croissance ne doive pas évoluer au regard du défi environnemental, mais parce que la recherche du bien-être pour tous demeure, pour Jean-Paul Fitoussi, ancrée sur l’emploi et le revenu (Fitoussi et Laurent 2008).

(x)

Si les très nombreuses contributions de Jean-Paul Fitoussi ont semblé relever de l’observation perspicace et de la controverse de politique économique ancrée sur les problèmes du moment, ce serait une faute que d’en ignorer la dimension théorique inscrite dans la recherche des fondements microéconomiques de la théorie macroéconomique. Cette recherche fait l’unité d’une pensée qui entend, assez systématiquement établir les effets globaux immédiats ou à plus long terme de l’hétérogénéité persistante ou accrue des marchés, des revenus, des nations, conçue comme hétérogénéité à la fois des situations et des comportements et comme source d’une dynamique des déséquilibres. Nonobstant la richesse des résultats des investigations poursuivies et de la rigueur formelle des analyses, cette démarche s’est heurtée aux difficultés d’une formalisation proprement mathématique. Mais sur ce terrain, Jean-Paul Fitoussi a, en partage avec Georgescu-Roegen (1971), la conviction que la théorie économique, qui décrit des phénomènes marqués par la nouveauté et l’hystérésis, ne peut se laisser enfermée dans des modèles que Georgescu- Roegen qualifie d’arithmomorphiques.

Dans la perspective de traiter des fondements microéconomiques de la théorie macroéconomique, Jean-Paul Fitoussi n’a abordé la question des formes d’organisation qui complètent le simple jeu du marché, en fait la question de l’entreprise, qu’à l’occasion d’une étude sur le mode de gouvernance des entreprises de service public confrontées à l’ouverture des marchés en Europe (Fitoussi 2003). Il y évoque la possibilité de créer une entreprise dite du troisième type dont l’État détient une partie du capital dont la caractéristique ou l’originalité, serait que chacune des catégories d’actionnaires continue à faire valoir ses propres préoccupations. Il y voit la possibilité d’articuler efficacement le court et le long terme face à des incertitudes particulièrement fortes, liées notamment à la transition écologique, quand les seuls signaux de prix ne fournissent pas l’information nécessaire. Sur ce sujet en fait très général, Jean-Paul Fitoussi adopte le même fil conducteur que dans ses autres travaux, celui consistant à reconnaître la multiplicité des intérêts et des objectifs en même temps que l’incomplétude de l’information exigeant une régulation qui ne se réduit pas au seul jeu du marché.

(xi)

Dans son dernier ouvrage paru, Jean-Paul Fitoussi emprunte une voie qui peut paraître surprenante à beaucoup : il dénonce l’empire du langage (Fitoussi 2020). Il ne s’écarte pourtant pas de l’une de ses préoccupations majeures qui lui avait fait écrire Le débat interdit puis Le théorème du lampadaire : il est impossible de concevoir ce que l’on ne sait pas ou ne veut pas nommer. L’économiste ici s’inquiète de ce que ceux-là même qui ont voulu contester analyses et prescriptions de la nouvelle école classique en ont utilisé le langage. Il n’y a pas, pour lui, de pensée unique mais un appauvrissement du langage qui empêche de s’emparer des vrais problèmes. Le risque est grand alors de se placer dans la position d’accepter le malheur des crises qu’il serait impossible de conjurer. Jean-Paul Fitoussi conserve, pour sa part, l’ultime conviction que notre destin est entre nos mains pourvu de pouvoir lever les limites imposées à la pensée par les règles du langage comme du gouvernement.

(xii)

Toute l’œuvre de Jean-Paul Fitoussi est une invitation à poursuivre dans la voie qu’il a choisie dès l’abord et qu’il a enrichie au fil des années. Cette voie a une dimension proprement scientifique qui ne peut que se nourrir de la lecture de ses travaux et de celle des grands auteurs à laquelle il nous a toujours convié. Elle a aussi une dimension politique et éthique qui veut que l’on ne puisse jamais dissocier la théorie économique de l’environnement institutionnel dans lequel elle est développée, une autre façon de dire que l’économie est politique.

Jean-Luc Gaffard (OFCE Sciences-Po, Université Côte d’Azur, Institut Universitaire de France)

Références

Clower R. (1965): ‘The Keynesian Counterrevolution: A Theoretical Appraisal’ in F.H. Hahn et F.P.R. Brechling eds., The Theory of Interest Rates, London: Macmillan.

Fitoussi J.-P. (1973) : Inflation, équilibre et chômage, Paris : Cujas.

Fitoussi J.-P. (1974) : Le fondement microéconomique de la théorie keynésienne, Paris : Cujas.

Fitoussi J.-P. (1983): ‘Modern Macroeconomic theory An Overview’, in Fitoussi J-P ed., (1983), Modern Macroeconomic theory, Oxford, Blackwell.

Fitoussi J.-P. (1995) : Le débat interdit, Paris : Arléa.

Fitoussi J.-P. (2002) : La règle et le choix, Paris : Le Seuil.

Fitoussi J.-P. (2003) : EDF, le marché et l’Europe, Paris : Fayard.

Fitoussi J.-P. (2004) : La démocratie et le marché, Paris : Grasset.

Fitoussi J.-P. (2005): ‘Macroeconomic Policies and Institutions’, Angelo Costa Lecture, Rivista di Politica Economica: 9-30.

Fitoussi J.-P. (2013) : Le théorème du lampadaire, Paris : Les Liens qui Libèrent.

Fitoussi J.-P. (2020) : Comme on nous parle, Paris : Les Liens qui Libèrent.

Fitoussi J.-P. et alii (2010): After the Crisis, the Way Ahead, Roma : LUISS University Press.

Fitoussi J.-P., Gaffard J.-L. et F. Saraceno (2010) : ‘Politiques macroéconomiques et réformes structurelles, bilan et perspectives de la gouvernance économique au sein de l’Union Européenne’, Revue d’Économie Politique 120 (2) : 247-268.

Fitoussi J.-P. et N. Georgescu-Roegen (1980): ‘Structure and Unvoluntary Unemployment’ in E. Malinvaud et J.-P. Fitoussi (eds.), Unemployment in Western Countries, London, Macmillan.

Fitoussi J.-P. et E. Laurent (2008) : La nouvelle écologie politique, Paris : Le Seuil.

Fitoussi J.-P. et A. Leijonhufvud (2002) : Préface de J.M. Keynes, La pauvreté dans l’abondance, Paris : Gallimard.

Fitoussi J.-P. et E. S. Phelps (1986):’Causes of the 1980’s Slump in Europe’, Brookings Paper on Economic Activity 2: 487-520.

Fitoussi J.-P. et E. S. Phelps (1988): The Slump in Europe: Reconstructing Open Economy, Oxford.

Fitoussi J.-P. et P. Rosanvallon (1996) : Le nouvel âge des inégalités, Paris : Le Seuil.

Fitoussi J.-P. et F. Saraceno (2010): ‘Inequality and Macroeconomic Performance’, Working Paper OFCE 2010-13.

Fitoussi J.-P. et F. Saraceno (2013): ‘European Economic Governance: The Berlin-Washington Consensus’, Cambridge Journal of Economics 37 (3): 479-496.

Georgescu-Roegen N. (1971): The Entropy Law and the Economic Process, Cambridge Mass.: Harvard University Press.

Laurent E. et J. Le Cacheux eds, (2015): Fruitful Economics, Papers in honor of and by Jean-Paul Fitoussi, London: Palgrave Macmillan

Leijonhufvud A. (1968): On Keynesian Economics and the Economics of Keynes, London: Oxford University Press.

Leijonhufvud A. (1973): ‘Effective Demand Failures’, Swedish Journal of Economics 75 (1): 27-48.

Leijonhufvud A. (1981): ‘The Wicksell Connection’ in Information and Coordination, Oxford: Oxford University Press.

Phelps E. S. (1970): Microeconomic Foundations of Inflation and Unemployment Theory, New York: Norton.

Stiglitz J, Sen A. et J.-P. Fitoussi (2009) : Richesse des nations et bien-être des individus, Paris : Odile Jacob.

Tobin J. (1972): ‘Inflation and Unemployment’, American Economic Review 62: 1-18.

Tobin J. (1995): ‘The Natural Rate as a New Classical Macroeconomics’, in R. Cross, The Natural Rate of Unemployment, Cambridge: Cambridge University Press.

Velupillaï K. V. (2012): ‘The Consummate Macroeconomist’ in Velupillaï K.V. ed., (2012): Macroeconomic Theory and Economic Policy: Essays in Honour of Jean-Paul Fitoussi, London: Routledge.